在最近发表在《PLOS数字健康》杂志上的一项研究中,研究人员评估并比较了大型语言模型(llm)与眼科领域人类专家的临床知识和诊断推理能力。

背景

生成预训练变形器(gpt), GPT-3.5和GPT-4,是基于大量基于互联网的数据集训练的高级语言模型。他们为ChatGPT提供动力,ChatGPT是一种会话人工智能(AI),以其在医疗应用中的成功而闻名。尽管早期的模型在专门的医学测试中挣扎,但GPT-4显示出显着的进步。对数据“污染”和测试分数的临床相关性的担忧仍然存在。需要进一步的研究来验证语言模型在现实世界医疗环境中的临床适用性和安全性,并解决其专业知识和推理能力方面的现有限制。

一个关于这项研究

皇家眼科学院院士(FRCOphth)第二部分考试的问题是从一本专业教科书中提取的,该教科书在网上并不普遍,最大限度地降低了这些问题出现在法学硕士培训数据中的可能性。共提取了360个选择题,涵盖6个章节,并分离出90个问题用于模拟考试,用于比较法学硕士和医生的表现。两名研究人员将这些问题与皇家眼科学院指定的类别相结合,并根据布鲁姆的认知过程分类水平对每个问题进行分类。不适合LLM输入的非文本元素的问题被排除在外。

考试问题被输入ChatGPT版本(GPT-3.5和GPT-4)以收集回答,必要时每个问题重复该过程多达三次。一旦Bard和HuggingChat等其他模型可用,就会进行类似的测试。根据教科书的定义,正确的答案被记录下来以供比较。

5名眼科专家、3名眼科实习医生和2名全科初级医生独立完成模拟考试,以评估模型的实际适用性。然后将他们的回答与法学硕士的回答进行比较。检查后,这些眼科医生使用李克特量表评估法学硕士的答案,以评估准确性和相关性,不知道哪个模型提供了哪个答案。

本研究的统计设计足够稳健,可以检测llm和人类医生之间的显著表现差异,旨在检验两者表现相似的零假设。应用各种统计检验,包括卡方检验和配对t检验来比较性能,并评估LLM响应与人类答案的一致性和可靠性。

研究结果

frcopth第二部分考试的360个问题中,有347个被选中使用,其中87个来自模拟考试章节。排除主要涉及图像或表格的问题,这些问题不适合输入到LLM界面。

性能比较显示,GPT-4的表现明显优于GPT-3.5,正确率为61.7%,而GPT-3.5的正确率为48.41%。正如英国皇家眼科学院所概述的那样,GPT-4能力的进步在不同类型的问题和科目中是一致的。详细的结果和统计分析进一步证实了GPT-4的强大性能,使其成为其他法学硕士和人类医生,特别是初级医生和实习生的竞争工具。

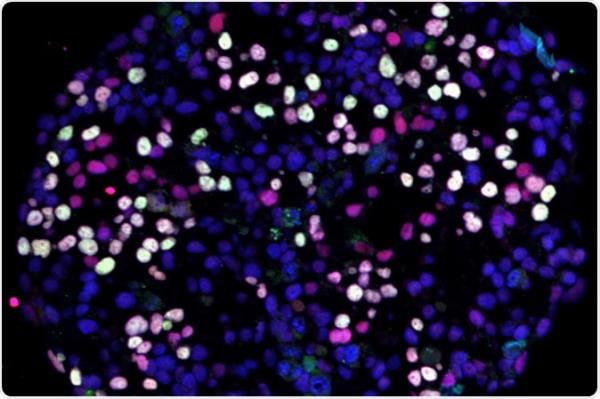

检查特征和颗粒性能数据。问题主题和类型分布与llm (GPT-3.5, GPT-4, LLaMA和palm2),专家眼科医生(E1-E5),眼科培训生(T1-T3)和非专科初级医生(J1-J2)的得分一起呈现。中位数并不一定等于总中位数,因为分数是不可能的。

在专门设计的87道模拟考试中,GPT-4不仅在llm中领先,而且与专业眼科医生得分相当,明显优于初级和实习医生。不同参与者组的表现表明,虽然专家眼科医生保持最高的准确性,但实习生接近这些水平,远远超过非专业眼科的初级医生。

统计测试还强调,不同法学硕士和人类参与者提供的答案之间的一致性一般为低到中等,表明群体之间在推理和知识应用方面存在差异。在比较模型和人类医生之间的知识差异时,这一点尤为明显。

根据真实考试标准对模拟问题的详细检查表明,模拟设置在难度和结构上与实际的FRCOphth Part 2笔试非常接近,并得到了相关眼科医生的同意。这种一致性确保了llm和人类反应的评估是建立在现实和临床相关的背景下。

此外,来自眼科医生的定性反馈证实了GPT-4比GPT-3.5的强烈偏好,这与定量表现数据相关。GPT-4更高的准确性和相关性评级强调了其在临床环境中的潜在效用,特别是在眼科。

最后,对所有法学硕士未能提供正确答案的实例的分析没有显示出与问题的复杂性或主题相关的任何一致模式。